Проблемы с Big-Data

Биг Дата дает нам беспрецедентные идеи и возможности, но также поднимает проблемы и вопросы, которые необходимо решить:

- Конфиденциальность данных – Big-Data, которую мы сегодня генерируем, содержит много информации о нашей личной жизни, на конфиденциальность которой мы имеем полное право. Все чаще и чаще нас просят найти баланс между количеством персональных данных, которые мы раскрываем, и удобством, которое предлагают приложения и услуги, основанные на использовании Биг Даты.

- Защита данных — даже если мы решаем, что нас устраивает то, что у кого-то есть наши данные для определенной цели, можем ли мы доверять ему сохранность и безопасность наших данных?

- Дискриминация данных — когда вся информация будет известна, станет ли приемлемой дискриминация людей на основе данных из их личной жизни? Мы уже используем оценки кредитоспособности, чтобы решить, кто может брать деньги, и страхование тоже в значительной степени зависит от данных. Нам стоит ожидать, что нас будут анализировать и оценивать более подробно, однако следует позаботиться о том, чтобы это не усложняло жизнь тех людей, которые располагают меньшими ресурсами и ограниченным доступом к информации.

Выполнение этих задач является важной составляющей Биг Даты, и их необходимо решать организациям, которые хотят использовать такие данные. Неспособность осуществить это может сделать бизнес уязвимым, причем не только с точки зрения его репутации, но также с юридической и финансовой стороны

Зачем государству ваши данные?

Как мы уже поняли, корпорации научились использовать данные своих клиентов (и просто разных людей) с собственной выгодой. Учитывая масштабы, речь идет об обезличенных данных, но все равно вопрос безопасности при использования такой информации остается открытым. Но возможность оперировать массивами данных интересует не только частные компании, было логично, что они заинтересуют и государства.

Многие россияне впервые услышали о «больших пользовательских данных» от генерального директора InfoWatch Натальи Касперской. Она в 2016 году заявила, что поисковые запросы, данные о геолокации, контактные данные, сообщения, фото и видео, которые собирают крупные IT-компании вроде Facebook, должны принадлежать государству. Сделать это она предлагает, законодательно заставив компании передавать сертификаты безопасности правительственным органам или просто переводить все эти данные в Россию (кстати, формально такой закон уже давно существует). И это осталось бы просто частным мнением, но Касперская на тот момент возглавляла подгруппу «Интернет + Общество» в рабочей группе под кураторством помощника президента России.

Аргументация простая – как только пользователь загрузил какие-то свои данные в интернет, они перестают ему принадлежать. А учитывая опыт других стран (например, Китая), было бы логично передавать все эти данные государству. Правда, в дальнейшем об этом ничего не было слышно – либо идея «заглохла», либо ее решили дальше не подвергать огласке.

Что касается Китая, там действительно есть истории о том, как Facebook согласился сотрудничать с правительством (передавать ему некоторую важную информацию пользователей), а Skype вообще отслеживает «неугодные» слова в сообщениях по определенному справочнику, и цензурирует их.

Последнее, о чем говорили в России в контексте Big Data – это предстоящая перепись населения, в ходе которой обещали использовать наработки по таким технологиям. Кроме прочего, переписчики будут пользоваться планшетными ПК, а данные будут как-то централизованно обрабатываться с использованием технологий Big Data.

Но главное – «большие данные» в России активно используются государственными органами в рамках всем известной «цифровизации». В частности, эти технологии уже используют в ФНС (которая вообще считается лидером по «цифровизации»), ФСБ, Пенсионном фонде, Фонде ОМС, Следственном комитете и некоторых других органах. Правда, конкретные результаты пока остаются по большей части за кадром – серьезных перемен в медицине не видно, а в налоговой службе все так же часто бывают сбои.

Кроме того, об использовании Big Data и технологий искусственного интеллекта часто говорят в «Сбербанке» – по словам руководства, это позволило сократить почти всех менеджеров среднего звена, а решения о выдаче кредита теперь часто принимает ИИ. Но снова, для рядовых клиентов «Сбербанк» – это все еще не самый современный банк со странным подходом к клиентам и частыми сбоями.

Логика возникновения и развития Data Science и Big Data

Безусловно, ярких событий, которые предшествовали, способствовали и благоприятствовали созданию Data Science и Big Data, намного больше, чем на таймлайне, но наша цель – показать, как разворачивается логика их возникновения.

Следующим пунктом в таймлайн можно вписать разработку стандартов в управлении Big Data. Первый международный стандарт в области больших данных появился в 2015 году благодаря усилиям экспертов Международного союза электросвязи. В 2018 году в этом направлении продвинулась и Международная организация по стандартизации (ISO). В 2021 году Росстандарт утвердил отечественные терминологические нормативы, которым должны следовать все участники рынка. Так появился ГОСТ «Информационные технологии. Большие данные. Обзор и словарь». Таким образом Россия преодолела некоторое отставание.

Надо признать, что для бизнеса стандарт ничего не меняет, однако в признании терминов есть очевидный плюс: участники рынка будут говорить на одном языке, а для компаний, которые еще только начинают работать с Big Data, это еще и ликбез.

По словам председателя совета директоров Института развития информационного общества Юрия Хохлова1, стандартизация терминов – только начало. В разработке еще 8 национальных стандартов в сфере больших данных, и здесь уже речь пойдет об эталонной архитектуре, безопасности, методах анализа, сценариях использования и т. д.

Путь от 15 к 50 тысячам заказов в сутки

Полгода у команды проекта ушло на подготовку сайта, после чего начался поиск партнеров. Многие рестораторы относились к новому бизнесу с изрядной долей скепсиса, но к моменту запуска 1 сентября 2009 года Delivery Club удалось обзавестись сотней партнеров.

Первоначальные инвестиции в проект составили 70 000 долларов – они закончились уже через полтора месяца. На тот момент ни о каких значимых результатах и ни о каком росте говорить не приходилось. Создатели Delivery Club оказались перед сложным выбором: опустить руки и покинуть рынок или продолжить путь.

В течение следующих полутора лет в проект было вложено еще порядка 400 000 долларов, и именно в этот период он начал расти.

Андрей Лукашевич: «Delivery Club, по сути, был первооткрывателем на российском foodtech-рынке – действовать приходилось методом проб и ошибок, поэтому и первые результаты появились спустя довольно ощутимое время. Многие люди с опаской относятся ко всему новому

Важно было донести до них, что новый сервис не стремится на них нажиться, а, напротив, способен заметно облегчить жизнь: можно не стоять весь вечер у плиты, а заказать любимое блюдо с доставкой до двери. И получить за это бонусы, благодаря которым можно снизить стоимость последующих заказов»

Рост такого бизнеса, как сервис доставки готовой еды, означает необходимость его масштабирования. С освоением новых городов у Delivery Club появлялись и новые проблемы. Сотрудничество с несколькими сотнями ресторанов в Москве – это одно, но, когда их становится несколько тысяч по всей стране, а количество заказов в день исчисляется десятками тысяч, это совсем другое.

Андрей Лукашевич: «Со временем мы осознали необходимость автоматизации процессов – человеческих ресурсов стало недостаточно для качественного функционирования сервиса. К вопросу мы подошли серьезно. Цифровые технологии используются у нас на всех этапах: от заказа до доставки. И все это для того, чтобы голодный пользователь получил свою еду как можно быстрее. Например, автоматизация взаимодействия с ресторанами позволяет исключить временные потери, связанные с такими традиционными инструментами коммуникации, как электронная почта и телефон: наши партнеры работают с системой автоматизации приема заказов VendorApp, либо их POS-системы интегрируются с нашей платформой. Благодаря этому 80% заказов сегодня обрабатываются автоматически, а среднее время приема заказа сократилось в четыре раза – с 10 до 2,5 минуты».

Сервис по доставке еды: удобства для клиентов

Сегодня компания считается одной из основных фирм, доставляющей еду и продукты в России. У курьеров Деливери Клаб основной режим работы не нормирован, поэтому они осуществляют доставку не только днем, но и ночью. Таким образом, большинство вопросов по этому поводу отпадают сами собой. Например, такие, как «До скольки или со скольки работает очень быстрая доставка Деливери Клаб?». Сервис функционирует в круглосуточном режиме, а значит, он очень удобен для всех клиентов. При этом у клиента всегда огромный выбор. Он может сделать заказ в одной из точек фастфуда или дорогом ресторане. Стоимость заказа никак не влияет на скорость его получения клиентом. Многие интересуются тем, сколько может стоить быстрая доставка в Деливери. Это зависит от выбранного кафе или проводимых в компании акций. В некоторых случаях она бесплатная. В среднем стоимость доставки не превышает 150 руб. Тем, кому интересно, где находится офис Деливери Клаб, следует знать, что их много, поскольку компания работает в нескольких регионах страны. Штаб-квартира расположена в Москве, на Ленинградском пр-те. Контактная информация представлена на странице https://www.delivery-club.ru/contacts.

Рекомендации «Вы заказывали»

Самый понятный сценарий exploitation в нашем приложении — это рекомендации тех ресторанов, в которых пользователь уже заказывал ранее. Существенная часть заказов совершается именно по такому сценарию. К тому же A/B-тест поднятия в топ ленты ресторана, в котором пользователь совершил последний заказ, уже показал статистически значимый результат и был давно внедрен в продакшен. Выглядит довольно логичной гипотеза о том, что если мы упростим сценарий перезаказа, то это повысит его удобство и улучшит бизнес-метрики.

Чтобы воплотить это в жизнь мы решили сделать отдельную карусель «Вы заказывали» (горизонтальную ленту рекомендаций), в которой находятся все рестораны, где пользователь ранее заказывал. Эта карусель содержит до 20 карточек заведений и расположена над основной лентой рекомендаций. Таким образом:

-

Пользователь получает быстрый доступ к наиболее релевантным ему ресторанам.

-

Так как все прошлые рестораны собраны в отдельной «карусели», из ленты их можно исключить.

-

Во-первых, это сократит количество мест, которое занимали прошлые заказы с N до 1.

-

Во-вторых, лента будет полностью работать на решение проблемы exploration, а задачей ML-модели в ленте станет предсказание нового для пользователя ресторана, в котором он закажет.

-

-

Для такой карусели мы можем сделать отдельную модель, прогнозируя, в каком ресторане из истории пользователя он закажет в следующий раз — потенциально можем улучшить опыт пользователя.

В теории звучит довольно логично и просто, но у реализации такой карусели и ML-модели сортировки ресторанов для неё есть несколько особенностей.

Во-первых, нам нужно отображать рекомендации в карусели в реальном времени. Техническое ограничение от команды разработки: 99-ый перцентиль времени ответа не более 100 мс под нагрузкой до 1 тыс. RPS. Поэтому мы решили делать offline-модель, которая заранее рассчитывает рекомендации для всех пользователей и обновляет их два раза в неделю.

Во-вторых, пользователь может заказывать в совершенно разных заведениях на разные адреса. Например, на работу — бизнес-ланч, а домой — суши и пиццу. Этот нюанс мы учли тем, что считали прогноз не для пользователя, а для пары пользователь-локация. Но ведь нам нужно заранее рассчитать все рекомендации. И если пользователей несколько миллионов, то всех пар пользователь-локация — миллиарды. Хранить в каком-нибудь key-value хранилище такое большое количество ключей проблематично. Мы решили обойти эту сложность так: округляем координаты до двух знаков после запятой (очень приближенно получаем квадраты 1х1 км, хотя на самом деле это не совсем квадраты из-за формы Земли). В продакшене нужно лишь округлить координату пользователя, чтобы получить соответствующий квадрат. Но даже таких квадратов слишком много, чтобы рассчитать все возможные комбинации пользователь-локация. Поэтому мы делали рекомендации только для комбинаций из прошлых заказов. А на случай, если пользователь решит совершить заказ в новой локации, у нас есть fallback рекомендаций на среднестатистического пользователя: из модели убираем все фичи, связанные с локацией.

В-третьих, хотелось бы иметь некие «логичные» рекомендации, потому что карусель «Вы заказывали» — это первый блок, который видит пользователь. Поэтому мы наложили в модели ограничение на монотонность по большинству из признаков. Например, вероятность следующей покупки в этом ресторане должна быть тем больше, чем:

-

больше заказов в этом ресторане у пользователя;

-

меньше прошло времени с последнего заказа в этом ресторане;

-

лучше было качество доставки (обратное от % опозданий, % сбоя в доставке).

В качестве модели мы использовали LightGBM. На тестовых данных она дает 74% precision@1. Из топовых признаков: количество заказов пользователя в ресторане, средняя возвращаемость пользователей в ресторан, расстояние от пользователя до ресторана.

Интересно, что признаки, связанные с давностью заказа, даже не входят в топ-5 по feature importance из shap. Более того, модель, которая сортирует рестораны в карусели по давности последнего заказа, показывает себя хуже по precision@1, чем случайная сортировка! Хотя ранее в проде в топе ленты отображался ресторан, в котором пользователя сделал последний заказ. Это аналог ML-модели только на одном признаке — времени с последнего заказа в ресторане с ограничением на монотонность. Справедливости ради стоит добавить, что такая же ситуация сохраняется и с остальными метриками, которые мы мониторим — precision@2 и MAP.

Кому это нужно

Встает логичный вопрос, как можно использовать информацию (если что, биг дата это сотни и тысячи терабайт)?

Даже не так. Вот есть информация. Так для чего придумали тогда биг дата? Какое применение у big data в маркетинге и в бизнесе?

- Обычные базы данных не могут хранить и обрабатывать (я сейчас говорю даже не про аналитику, а просто хранение и обработку) огромного количества информации.Биг дата же решает эту главную задачу. Успешно хранит и управляет информацией с большим объемом;

- Структурирует сведения, приходящие из различных источников (видео, изображений, аудио и текстовых документов), в один единый, понятный и удобоваримый вид;

- Формирование аналитики и создание точных прогнозов на основании структурированной и обработанной информации.

Это сложно. Если говорить просто, то любой маркетолог, который понимает, что если изучить большой объем информации (о Вас, Вашей компании, Ваших конкурентах, Вашей отрасли), то можно получить очень приличные результаты:

- Полное понимание Вашей компании и Вашего бизнеса со стороны цифр;

- Изучить своих конкурентов. А это, в свою очередь, даст возможность вырваться вперед за счет преобладания над ними;

- Узнать новую информацию о своих клиентах.

И именно потому, что технология big data дает следующие результаты, все с ней и носятся. Пытаются прикрутить это дело в свою компанию, чтобы получить увеличение продаж и уменьшение издержек. А если конкретно, то:

- Увеличение кросс продаж и дополнительных продаж за счет лучшего знания предпочтений клиентов;

- Поиск популярных товаров и причин почему их покупают (и наоборот);

- Усовершенствование продукта или услуги;

- Улучшение уровня обслуживания;

- Повышение лояльности и клиентоориентированности;

- Предупреждение мошенничества (больше актуально для банковской сферы);

- Снижение лишних расходов.

Самый распространенный пример, который приводится во всех источниках — это, конечно ж, компания Apple, которая собирает данные о своих пользователях (телефон, часы, компьютер).

Именно из-за наличия эко-системы корпорация столько знает о своих пользователях и в дальнейшем использует это для получения прибыли.

Эти и другие примеры использования Вы можете прочитать в любой другой статье кроме этой.

Современный пример

Я же Вам расскажу о другом проекте. Вернее о человеке, который строит будущее, используя big data решения.

Это Илон Маск и его компания Tesla. Его главная мечта — сделать автомобили автономными, то есть Вы садитесь за руль, включаете автопилот от Москвы до Владивостока и… засыпаете, потому что Вам совершенно не нужно управлять автомобилем, ведь он все сделает сам.

Казалось бы, фантастика? Но нет! Просто Илон поступил гораздо мудрее, чем Google, которые управляют автомобилями с помощью десятков спутников. И пошел другим путем:

- В каждый продаваемый автомобиль ставится компьютер, который собирают всю информацию. Всю — это значит вообще всю. О водителе, стиле его вождения, дорогах вокруг, движении других автомобилей. Объем таких данных доходит до 20-30 ГБ в час;

- Далее эта информация по спутниковой связи передается в центральный компьютер, который занимается обработкой этих данных;

- На основе данных big data, которые обрабатывает данный компьютер, строится модель беспилотного автомобиля.

К слову, если у Google дела идут довольно скверно и их автомобили все время попадают в аварии, то у Маска, за счет того, что идет работа с big data, дела обстоят гораздо лучше, ведь тестовые модели показывают очень неплохие результаты.

https://www.youtube.com/watch

Но… Это все из экономики. Что мы все о прибыли, да о прибыли? Многое, что может решить биг дата, совершенно не связано с заработком и деньгами.

Статистика Google, как раз таки основанная на big data, показывает интересную вещь.

Перед тем, как медики объявляют о начале эпидемии заболевания в каком-то регионе, в этом регионе существенно возрастает количество поисковых запросов о лечении данного заболевания.

Таким образом, правильное изучение данных и их анализ может сформировать прогнозы и предсказать начало эпидемии (и, соответственно, ее предотвращение) гораздо быстрее, чем заключение официальных органов и их действия.

Кадры решают

Особенность foodtech-рынка в том, что он находится на стыке двух сфер: IT и HoReCa. Это значит, что мало нанять крутых разработчиков – нужны еще и квалифицированные специалисты индустрии гостеприимства. Не говоря уже о маркетологах и пиарщиках. И в этом смысле присоединение к Mail.Ru Group очень помогло развитию Delivery Club: проект получил карт-бланш на привлечение лучших специалистов.

Андрей Лукашевич: «Зарубежным фудтех-проектам сложно работать в России еще и из-за несовершенной системы управления: в большинстве случаев местным офисом руководят в удаленном режиме из-за рубежа, что часто приводит к серьезным (если не сказать фатальным) кадровым ошибкам. Найти хорошего специалиста на чужом рынке, руководствуясь собственными представлениями и не имея возможности проверить его квалификацию, крайне сложно. Прибавьте к этому ослабленный контроль, почти всегда являющийся следствием удаленного управления, – и станет ясно, почему иностранцам так сложно закрепиться на нашем рынке».

Группы игроков на рынке Больших Данных

Рассмотрим, кто входит в структуру рынка и какой выбрать вариант для внедрения технологии в вашу компанию. На рынке Big Data можно выделить несколько направлений:

- компании, в задачи которых входит хранение и начальная обработка данных (Oracle, SAP, Teradata, Microsoft, ЕМС, IBM и др.);

- разработчики ПО – обработка и поиск информации (АлгоМост, CleverData, IBS, Google BigQuery, Amazon, и др.);

- компании, которые создают системы на стороне заказчика (Крок, Форс и др.);

- фирмы-разработчики готовых приложений или платформ (часто в облаке), для широкой аудитории. Оптимальный вариант для любого бизнеса. (Auditorius, Cross, 1С-Битрикс BigData, Usalytics, Opiner и др.).

Какие задачи решают Большие Данные

Основные глобальные задачи, с которыми успешно справляется технология:

- сбор и хранение больших потоков непрерывно изменяющихся данных;

- управление массивами растущей информации;

- структурирование разных типов данных, поиск неявных зависимостей;

- анализ полученных данных и точное прогнозирование бизнес-процессов.

Если рассматривать более узкие задачи, которые помогает решать Big Data, то можно выделить изучение поведения клиентов и таргетинг, анализ и планирование финансовых операций, продажи и планирование запасов, анализ жизненного цикла продукта и др. Все большая роль отводится этой технологии в сфере управления человеческими ресурсами.

Способы интерпретации и представления в BI

Крайне важна и визуализация полученных результатов работы с Big Data. Специалисты по обработке данных с помощью инструментов BI (business intelligence) пакетов помогают менеджерам выявлять тенденции и закономерности подавая информацию в доступной для нетехнических специалистов форме.

Визуализация данных обеспечивает графическое представление информации, которая удовлетворяет потребность в передаче результатов анализа больших данных тем, кто находится за пределами отдела аналитики.

На примере отчета в Power BI видно, как наглядно может быть представлена комплексная метрика LTV и связанные показатели, на которые опираются в работе несколько департаментов компании.

Чтобы добиться такого результата, специалист по визуализации данных стремиться достичь тонкого баланса между формой и функцией. Типы визуализации для построения дашбордов (англ. dashboard — информационная панель) включают диаграммы, таблицы, графики, карты, инфографику и многое другое.

Таким образом, лучшие BI-платформы визуально отображают основные бизнес-показатели и их динамику, позволяя заинтересованным сторонам использовать эту информацию для визуальной аналитики Big Data.

Будущее Big Data: аналитика и управление данными

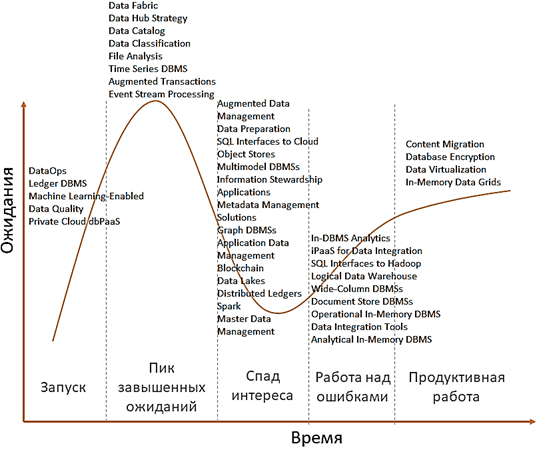

Интересно также отметить, что аналитики Gartner составили отдельный прогноз по наиболее перспективным технологиям в области управления данными (Data Management), разделяя сферу Big Data от искусственного интеллекта. В частности, согласно этому исследованию, сейчас на пике завышенных ожиданий находятся следующие технологии управления данными :

- Data Fabric – фабрики данных, о которых мы рассказываем здесь;

- Data Hub Strategy – стратегические хабы данных;

- Data Catalog – каталоги данных;

- Data Classification – классификация данных;

- File Analysis – файловой анализ;

- Time Series DBMS – СУБД временных рядов;

- Augmented Transactions – расширенные транзакции;

- Event Stream Processing – потоковая обработка событий, например, использованием таких Big Data инструментов, как Apache Kafka, Spark, Storm, Flink и пр.

На этапе старта Gartner располагает концепцию DataOps, специальные СУБД для хранения бухгалтерских данных типа гроссбуха для биткоинов (Ledger DBMS), ML-инструменты поддержки качества данных (Machine Learning-Enabled Data Quality) и частные СУБД в виде облачных платформ (Private Cloud dbPaaS). Спад интереса отмечается к следующим технологиям :

- Augmented Data Management – расширенное управление данными;

- Data Preparation – подготовка данных (к машинному обучению и аналитике);

- SQL Interfaces to Cloud Object Stores – SQL-интерфейсы к облачным хранилищам;

- Multimodel DBMSs – мультимодельные СУБД;

- Master Data Management, Information Stewardship Applications и Application Data Management – приложения для управления данными;

- Metadata Management Solutions – решения для управления метаданными;

- Graph DBMSs – графовые СУБД;

- Blockchain – блокчейн;

- Data Lakes – озеро данных или корпоративное хранилище данных, например, на базе Apache Hadoop;

- Distributed Ledgers – распределенные кошелки для биткоинов и подобных криптовалют;

- Apache Spark.

Доверие общества восстанавливается к аналитическим СУБД (In-DBMS Analytics, Analytical In-Memory DBMS), SQL-интерфейсам к Apache Hadoop (например, Cloudera Impala, Apache Phoenix, Drill и Hive), логическим хранилищам данных (Logical Data Warehouse), колоночным и документо-ориентированным СУБД (Wide-Column DBMS и Document Store DBMS), инфраструктурным платформам и инструментам для интеграции данных (iPaaS for Data Integration и Data Integration Tools), а также к резидентным базам данных (Operational In-Memory DBMS), которые размещаются в оперативной памяти. Наконец, на плато продуктивности сегодня находятся различные системы миграции контента (Content Migration), криптографические СУБД (Database Encryption), виртуализация данных (Data Virtualization) и резидентные сетки данных (In-Memory Data Grids) .

Самые перспективные технологии Big Data и другие приложения Data Management: аналитический прогноз Gartner 2019

На практике, по крайней мере, в России технологии управления данными только начинают входить в фазу интереса и востребованности. В частности, эту тенденцию подтверждает растущий спрос на DataOps-инженеров и государственный тренд на цифровизацию. Разговор о наиболее перспективных с точки зрения Gartner ИТ-тенденциях мы продолжим в следующий раз.

Как эффективно использовать эти и другие технологии больших данных, машинного обучения для цифровизации своего бизнеса, вы узнаете на наших образовательных курсах в лицензированном учебном центре обучения и повышения квалификации руководителей и ИТ-специалистов (менеджеров, архитекторов, инженеров, администраторов, Data Scientist’ов и аналитиков Big Data) в Москве:

Аналитика больших данных для руководителей

Смотреть расписание

Записаться на курс

Источники

- https://ru.wikipedia.org/wiki/Gartner

- https://www.gartner.com/smarterwithgartner/top-trends-on-the-gartner-hype-cycle-for-artificial-intelligence-2019

- https://habr.com/ru/post/475032/

- https://www.gartner.com/en/documents/3955768/hype-cycle-for-data-management-2019

Где используют методы Больших Данных

Наибольшее развитие концепции Big Data наблюдается в тех отраслях, где создаются и обрабатываются огромные потоки информации в режиме онлайн. Их используют в торговле, инжиниринге, здравоохранении, различных госучреждениях, телекоммуникациях, финансовой сфере и логистике. Основные три направления, в которых компании применяют Big Data, – это клиентский сервис (предпочтения клиентов), оценка эффективности бизнес-процессов и управление рисками. Рассмотрим популярные сферы применения технологии Больших Данных.

Сфера финансов

Big Data ускоряют принятие решения о выдаче кредита, на основе анализа операций клиента подбирают оптимальный пакет банковских услуг, анализируют его кредитоспособность. Компании, которые используют технологию, могут выполнить мгновенную обработку персональных данных клиента.

Торговля

За время деятельности магазина/компании накапливается много данных о покупателях, поставщиках, товарах и управлении запасами. На основе обработки этой информации можно управлять движением товара, прогнозировать продажи и уменьшать затраты.

Отрасль телекоммуникаций

Эта отрасль владеет одним из самых объемных массивов данных, проводит подробный анализ информации о клиентах. Компании выполняют сегментацию аудитории, анализ трафика, борьбу с мошенничеством. Главная задача – повышение лояльности текущих и привлечение новых клиентов.

Применение в России

Однако Россия как всегда немного притормаживает. Так, само определение big data в России появилось не более, чем 5 лет назад (я сейчас именно про обычные компании).

И это не смотря на то, что это один из самых быстрорастущих рынков в мире (наркотики и оружие нервно курят в сторонке), ведь ежегодно рынок программного обеспечения для сбора и анализа big data прирастает на 32%.

Чтобы охарактеризовать рынок big data в России, мне вспоминается одна старая шутка. Биг дата это как секс до 18 лет. Все об этом говорят, вокруг этого много шумихи и мало реальных действий, и всем стыдно признаться, что сами-то они этим не занимаются. И правда, вокруг этого много шумихи, но мало реальных действий.

Хотя известная исследовательская компания Gartner уже в 2015 году объявила, что биг дата уже не возрастающий тренд (как, кстати, и искусственный интеллект ), а вполне самостоятельные инструменты для анализа и развития передовых технологий.

Наиболее активные ниши, где применяется big data в России, это банки/страхование (недаром я начал статью с главы Сбербанка), телекоммуникационная сфера, ритейл, недвижимость и… государственный сектор.

Для примера расскажу более подробно о паре секторов экономики, которые используют алгоритмы big data.

1. Банки

Начнём с банков и той информации, которую они собирают о нас и наших действиях. Для примера я взял ТОП-5 российских банков, которые активно инвестируют в big data:

- Сбербанк;

- Газпромбанк;

- ВТБ 24;

- Альфа Банк;

- Тинькофф банк.

Особенно приятно видеть в числе российских лидеров Альфа Банк. Как минимум, приятно осознавать, что банк, официальным партнером которого ты являешься, понимает необходимость внедрения новых маркетинговых инструментов в свою компанию.

Но примеры использования и удачного внедрения big data я хочу показать на банке, который мне нравится за нестандартный взгляд и поступки его основателя.

Я говорю про Тинькофф банк. Их главной задачей стояла разработка системы для анализа больших данных в режиме реального времени из-за разросшейся клиентской базы.

Результаты: время внутренних процессов сократилось минимум в 10 раз, а для некоторых — более, чем в 100 раз.

Ну и небольшое отвлечение. Знаете, почему я заговорил про нестандартные выходки и поступки Олега Тинькова? Просто на мой взгляд именно они помогли ему превратиться из бизнесмена средней руки, коих тысячи в России, в одного из самых известных и узнаваемых предпринимателей. В подтверждение посмотрите это необычное и интересное видео:

https://www.youtube.com/watch

2. Недвижимость

В недвижимости все гораздо сложнее. И это именно тот пример, который я хочу Вам привести для понимания биг даты в пределах обычного бизнеса. Исходные данные:

- Большой объем текстовой документации;

- Открытые источники (частные спутники, передающие данные об изменениях земли);

- Огромный объем неконтролируемой информации в Интернет;

- Постоянные изменения в источниках и данных.

И на основе этого нужно подготовить и оценить стоимость земельного участка, например, под уральской деревней. У профессионала на это уйдет неделя.

У Российского общества оценщиков & РОСЭКО, собственно которые и внедрили себе анализ big data с помощью программного обеспечения, уйдет на это не более 30 минут неторопливой работы. Сравните, неделя и 30 минут. Колоссальная разница.

Как работать в регионах

В Москве и Питере доставка изначально была дополнением к ресторанному бизнесу. В маленьких же городах ресторанного рынка почти не было. Там люди идут в супермаркет, покупают пачку пельменей за 150 рублей и едят. Эту привычку нужно вытеснять. Производители, которые обеспечивают поставками региональные рестораны и супермаркеты, могут делать очень дешевую еду для доставки. Даже дешевле, чем если бы вы готовили сами. У меня, кстати, так и получается: я иду в магазин, покупаю кучу ингредиентов на тысячу рублей. Половину из них порчу, половину не использую. За тысячу я мог бы заказать два обеда. Мобильные приложения пересадили людей с маршруток на такси, а мы с коллегами из ресторанного бизнеса должны пересаживать людей с магазинных пельменей на доставку.

Как работает технология Big-Data?

Биг Дата работает по принципу: чем больше вы знаете о том или ином предмете или явлении, тем более достоверно вы сможете достичь нового понимания и предсказать, что произойдет в будущем. В ходе сравнения большего количества точек данных возникают взаимосвязи, которые ранее были скрыты, и эти взаимосвязи позволяют нам учиться и принимать более взвешенные решения. Чаще всего это делается с помощью процесса, который включает в себя построение моделей на основе данных, которые мы можем собрать, и дальнейший запуск имитации, в ходе которой каждый раз настраиваются значения точек данных и отслеживается то, как они влияют на наши результаты. Этот процесс автоматизирован — современные технологии аналитики будут запускать миллионы этих симуляций, настраивая все возможные переменные до тех пор, пока не найдут модель — или идею — которые помогут решить проблему, над которой они работают.

Бил Гейтс висит над бумажным содержимым одного компакт диска

До недавнего времени данные были ограничены электронными таблицами или базами данных — и все было очень упорядочено и аккуратно. Все то, что нельзя было легко организовать в строки и столбцы, расценивалось как слишком сложное для работы и игнорировалось. Однако прогресс в области хранения и аналитики означает, что мы можем фиксировать, хранить и обрабатывать большое количество данных различного типа. В результате «данные» на сегодняшний день могут означать что угодно, начиная базами данных, и заканчивая фотографиями, видео, звукозаписями, письменными текстами и данными датчиков.

Чтобы понять все эти беспорядочные данные, проекты, имеющие в основе Биг Дату, зачастую используют ультрасовременную аналитику с привлечением искусственного интеллекта и компьютерного обучения. Обучая вычислительные машины определять, что же представляют собой конкретные данные — например, посредством распознавания образов или обработки естественного языка – мы можем научить их определять модели гораздо быстрее и достовернее, чем мы сами.